Németország változatos ipari szektorainak tucatnyi szervezetét érte koordinált hackertámadás. A támadás egy részét külön figyelemmel vizsgálták a biztonsági szakemberek, mert önmagában a malware-ben ugyan semmi érdekes nem volt, viszont egyértelműnek tűnik, hogy a kódját mesterséges intelligencia generálta. Az MI generálta malware-t a TA547 IAB (Initial Access Broker) használta adathalász támadásokhoz.

Az IAB számítógépes rendszerekbe és hálózatokba beszivárgó, nem engedélyezett hozzáféréseket más rosszindulatú szereplőknek értékesítő aktor. Nagyon jó a biztonsági szempontból gyenge pontok azonosításában és kiaknázásukban, zsarolószoftveres (ransomware) csoportoknak és más rosszfiúknak nyújt fontos szolgáltatásokat. Általában közvetítőként teszi lehetővé a behatolást megfertőzött rendszerekbe.

A támadások az új idők előhírnökei is lehetnek, pánikra viszont nincs még ok. A védekezés ugyanaz, független a program írójának kilététől. A következő évek nagy nyelvmodellek (large language models, LLM) írta vírusai nem lesznek kifinomultabbak az ember által kódoltaknál. A hackerek egyelőre tehetségesebb vírusfejlesztők a mesterséges intelligenciánál.

TA547 nem ismeretlen a pénzügyileg motivált cybertámadásokkal foglalkozó szakemberek előtt, Az évek múlásával a fejlesztési ciklusok iterációi, más malware-ek adaptálása, új technikák kipróbálása viszont mind felgyorsultak.

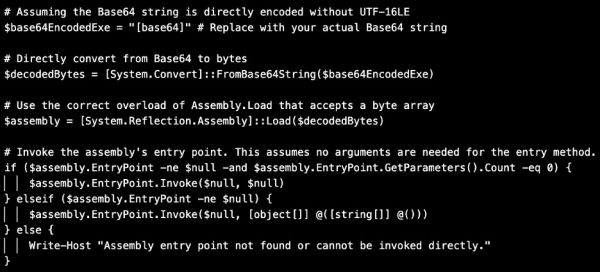

Támadásai rövid, személyeskedő e-mailekkel kezdődnek, általában valamilyen cégnek adja ki magát. Az e-mailek jelszóval védett ZIP-, azok tömörített LNK-fájlokat tartalmaznak. Utóbbiak aktiválják az infókat eltulajdonító Powershell szkriptet.

A Powershell az LLM-ek generálta kódok karakterjegyeit viseli, tehát a mögötte álló személyek valamilyen chatbotot használtak a megírásához.

Az MI megjelenésében semmi különös nincs. Hackerek ugyanúgy kísérleteznek a technológiával, mint bárki más. Kíváncsiak, hogyan könnyíti meg, teszi eredményesebbé és gyorsabbá tevékenységüket. Egyesek MI-vel kutakodnak a célponttal, emergens módon kialakuló gyengeségeivel kapcsolatban.

Egyelőre nincs bizonyíték arra, hogy a hackerek jobb malware-eket íratnak MI-vel, mintha saját maguk fejlesztenék a vírust. Malware-írásban még az ember az első, ráadásul az LLM-ek fejlesztői megtették a szoftvereik rosszindulatú használata elleni óvintézkedéseket.

Kérdés, meddig nincs fokozott veszély. Ha pedig jönnek a gép által írt szuper malware-ek, a védekezés nagyjából ugyanaz lesz, mint ma – csak gyorsabb és szofisztikáltabb.