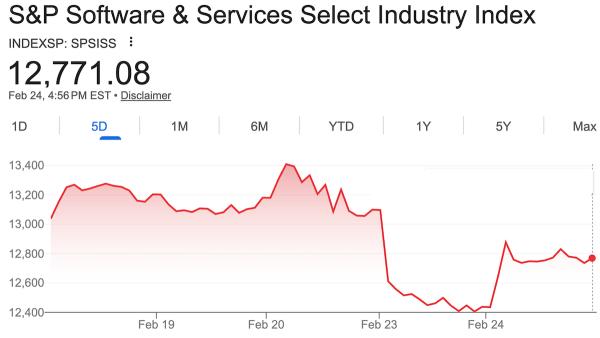

A befektetőket aggasztja, hogy a mesterséges intelligencia által támogatott kódoló-rendszerek képesek lesznek népszerű szoftvereszközök reprodukálására, ezért az S&P Software & Services Index árfolyama januárban zuhanni kezdett. A szervezet olyan szoftveróriásokat tartalmaz, mint a Microsoft, az Oracle, a Salesforce és a Workday. Az index értékének huszonöt százalékát veszítette január 12. (az Anthropic ezen a napon mutatta be a professzionális munkára tervezett Claude Cowork ágenst), és február 23. között.

A részvények eladása főként a webes szoftver-előfizetések eladóit és a szoftver mint szolgáltatás (SaaS) néven ismert szektort érintik. Olyannyira, hogy befektetési stratégák már SaaSpocalypse-ről beszélnek.

Az Anthropic további termékeivel olajat öntött a tűzre. Ezeket SaaS-ajánlatok által jellemzően elvégzett feladatok ellátására terveztek. Január harmincadikán tizenegy nyílt forráskódú bővítményt adtak ki. Funkcióik közé tartozik a naptárkezelés, a dokumentumkeresés és -lekérés, az értékesítés, a pénzügyi elemzés, az adatlekérdezések és -vizualizációk, a jogi felülvizsgálat és megfelelés, a marketing, az ügyfélszolgálat, a termékmenedzsment és a biológiai kutatás, valamint egy, további bővítményeket létrehozó és testre szabó plugin.

Négy nappal később az S&P Software & Services Index négy százalékot esett, eltörölve több mint 285 milliárd dollárnyi piaci kapitalizációt. A JPMorgan szoftverindexe hét százalékot veszített értékéből. A LegalZoom.com részvényei közel húsz százalékot, a Thompson Reuters részvényei pedig tizenhat százalékot estek.

Február huszadikán az Anthropic bemutatta a Claude Code Security nevű cyberbiztonsági alkalmazást; a szoftveres sebezhetőségek emberi felülvizsgálat utáni észlelése és javítása a rendeltetése. Ezt követően biztonsági szoftvereket gyártó vállalatok részvényeinek eladása következett. A Google CodeMender és az OpenAI Aardvarkja hasonló MI-alapú biztonsági funkciókat lát el.

Február 24-én az Anthropic bejelentette, hogy integrációkat köt a Cowork által fenyegetett néhány vállalattal: Docusign, FactSet, Google Gmail, Intuit, Salesforce. Az alkalmazásaik megkerülése helyett a Cowork bővítmények új hulláma közvetlenül kapcsolódik hozzájuk. Ez a megközelítés nagyobb kontrollt biztosít a vállalatoknak a bővítmények használatának és monitorozásának módja felett.

A SaaS részvények árfolyama erre megugrott, bár nem nyerték vissza korábbi veszteségeiket. Valószínűleg nincs is vége, csak MI-natívvá alakul át.