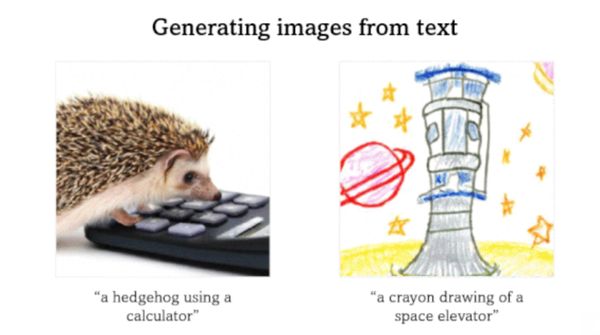

Az OpenAI DALL.E rendszere szöveges leírásokból készít képeket. Legújabb frissítése sokat javított rajta, lényegében az alapoktól kezdve újraírták az egészet. A leírások megjelenítéséhez a korábbi CLIP képosztályozót, képgeneráláshoz egy nemrég ismertetett módszert használnak.

A GLIDE modell a szöveges inputra reagálva alkot és szerkeszt képeket. Gyakorlás közben a generatív modell „zajos” képekkel dolgozik, és megtanulja eltávolítani a zajt. Következtetésnél szintén tiszta zajjal kezdi, majd képet generál.

Korábbi tanulmányokból tudjuk, hogy ha osztály-címkét adunk egy képhez, a diffúziós modell az osztály alapján generál új képeket. GLIDE transzformerrel és konvolúciós ideghálóval (ADM) dolgozik. DALL.E-hez hasonlóan, az interneten gyűjtött 250 millió kép-szövegpáron gyakorolt, viszont DALL.E-vel ellentétben, a fejlesztők minden egyes képet inkrementálisan egészítettek ki zajjal, hogy darabonként százötven, egyre „zajosabb” képet hozzon létre.

A transzformer gyakorlás közben tanulta meg, hogy az input szöveget megjelenítse. A megjelenítésekből és a zajos példából kiindulva, ADM menet közben, sajátította el, hogyan definiálja a sorozat mindenkori megelőző képéhez adott zajt.

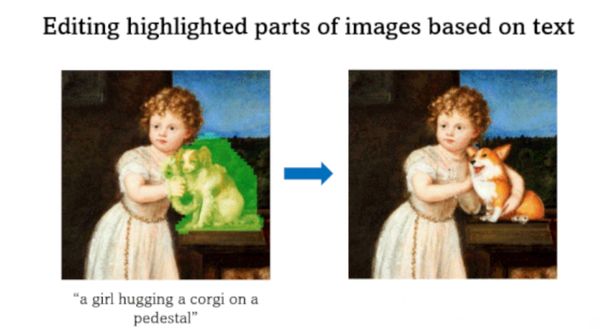

Következtetéskor GLIDE százötvenszer határozta meg és távolította el a zajt, és mindig képet alkotott. Következő lépésben a kutatók növelték a szöveg szerepét. A modell megint a zajjal kezdte, először ignorálta a szöveges reprezentációt, másodszor már nem. Felmérte a két zaj közötti különbséget, az eredményt eltávolítandó zaj generálására használta fel. A szöveges leírásoknak megfelelő képek szerkesztését a képek egyes részeinek zajjal történő helyettesítésével kezdték, amin a rendszer több iterációban hajtott végre módosításokat, a kép többi részét viszont intakt hagyta.

GLIDE teljesítménye ezer összehasonlítás 91 százaléka alapján fotorealisztikusabb lett, mint DALE.E-é. Ezek a képek az esetek 83 százalékában jobban hasonlítanak a szöveges inputhoz. GLIDE élethű outputjai viszont a következtetési idő rovására mennek. Tizenöt másodpercig, sokkal tovább tart, mint a generatív ellenséges hálózatok (GAN) szöveg-kép generátorainál. Azoknak a másodperc töredékét veszi igénybe egy ilyen művelet. A közeljövőben valószínűleg GLIDE felgyorsítása lesz az egyik legfontosabb fejlesztési szempont.

Az újítás azért fontos, mert a generatív modelleket nehéz intuitív módon vezérelni. A természetes nyelven keresztül történő közvetlen képgenerálással viszont új lehetőségek nyílnak meg.