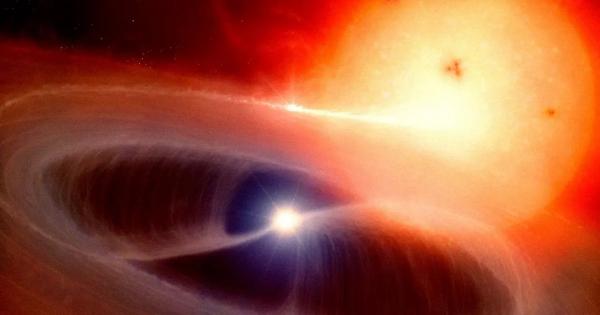

Nemzetközi csillagászcsoport két szülőcsillaga körül rendkívül fura, zavarodott módon keringő exobolygót figyelt meg. A Nu Octantis rendszerben, tőlünk hetvenkét fényév távolságra található égitest kétszer akkora, mint a Jupiter. 2004-ben fedezték fel, de mivel túl közel van ikercsillagaihoz, létezése több tudós szerint már akkor lehetetlennek tűnt.

A Nature-ben megjelent friss tanulmány szerzői bizarrnak tűnő új elmélettel magyarázzák a rendkívül szoros pályán keringő égitest létezését: a bolygó és az egyik csillag két ellentétes irányban kering a másik csillag körül, azaz a bolygó retrográd mozgást végez, vagy fordítva kering a csillag körül.

Létezése ellentmondásos, mert nem voltak megfigyelési előzményei, és azt várjuk, hogy az égitestek előrehaladó pályát alakítanak ki, ha a csillagokkal egyidőben jönnek létre – magyarázza a hongkongi Man Hoi Lee, a tanulmány egyik szerzője.

A problémát tovább bonyolítja, hogy a tudósok szerint a bolygó keringési pályája a két csillag közé kerül. Mozgása olyan, mint egy szabálytalan tánc, és egyben rámutat, mennyi mindent kell még megtanulnunk többcsillagos rendszerek bonyolult pályamechanikájáról.

A jelenségből egyértelműen következik, hogy a kutatóknak az eddig gondoltaknál több csillag-bolygókeletkezési és fejlődési forgatókönyvvel kell számolniuk.

A rendszer egyik csillaga életciklusa végéhez közeledő fehér törpe. A becslések alapján 2,9 milliárd éve keletkezett Nu Octantis ezzel még egzotikusabbnak, furcsábbnak tűnik.

A bolygó azonban jóval később jött létre, és vagy mindkét csillag körül keringett, s miután az egyikből fehér törpe lett, szokatlan pályára váltott, vagy a törpéből gyűjtötte össze jelentős tömegét. A pontosabb képhez mindenesetre további kutatások szükségesek.

Más bolygók szoros bináris rendszerekben történő megfigyelése kései vagy főciklus utáni csillagkomponensekkel, további fogódzókat ad bolygórendszerek kialakulásának és fejlődésének jobb megértéséhez – összegeznek a hasonló bináris csillagrendszerek, mint a Jupiternél hatszor nagyobb tömegű gázóriásnak otthont adó HD 59686 közelebbi megismerésére készülő kutatók.