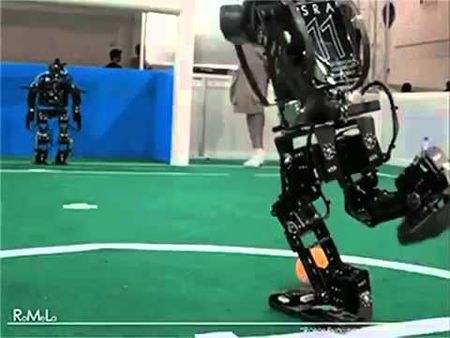

A focibot, egy kapus ki akarja védeni a csatár lövését, védés helyett azonban földre veti magát, és a lábával fura mozdulatokat tesz. A csatár lövés helyett pedig táncolni kezd, majd hirtelen összeesik.

Ketten játszanak, 1-0ra vezet a kapus.

A kaotikus jelenet tanulsága, hogy mély megerősítéses tanulással gyakorló mesterséges intelligenciák sebezhetőbbek, mint gondoltuk. A következmények súlyosak lehetnek. (Ez a technika áll például a DeepMind AlphaZeroja, az OpenAI Five és az önvezető autók, automatizált kereskedőrendszerek és játékok mögött is.)

Az utóbbi években kutatók több módszert találtak a címkézett adatokon, azaz felügyelt tanuláson gyakorló MI-k meghackelésére. Elég néhány apró változtatás az inputon (egy képen pár pixel), és az ellenséges támadásra nincs megoldás.

Most az újabb és kevesebbet tanulmányozott megerősítéses tanulásról is ugyanez derült ki. A módszerrel az MI-k elsajátítják, hogyan viselkedjenek különböző helyzetekben. Ha helyesen cselekednek, jutalmat kapnak. Megtanulnak akcióterveket készíteni, ezek a tervek teszik lehetővé, hogy például autót vezessenek.

2017-ben már kiderült, hogy a klasszikus videójáték Pongot játszó MI egyetlen pixel módosításával alaposan megzavarható.

Adam Gleave, a Berkeley-i Kaliforniai Egyetem kutatója viszont már nem nemlétező dolgokat akar láttatni MI-kkel, hanem a körülöttük lévő dolgok viselkedését változtatja meg. Korábban nem foglalkoztak ezzel a fenyegetés-modellel.

A stratégia nyugtalanítóbb, mint a felügyelt tanulással gyakorló MI-ket ért támadások. Az ok: az MI teljes magatartását érinti, például önvezető autónál nem egy-két szenzor hibásodik meg, hanem a teljes kontrollt elveszíti, nagy sebességgel nekimehet egy szabályosan közlekedő gyalogosnak stb.

Gleave és kollégái két-résztvevős játékokat játszattak botokkal – fociztak, versenyt futottak, szumóztak. Tisztában voltak ellenfeleik testhelyzetével és mozgásaival.

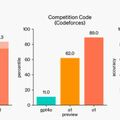

Következő körben egy második „botcsapatot” gyakoroltattak, amelyek nagyon hamar rájöttek az ellenlépésre. Az áldozataik által a játék elsajátítására fordított időnek kevesebb mint 3 százaléka elegendő volt nekik.

Nem lettek jobb játékosok, csak kitanulták, hogyan kuszálható össze teljesen ellenfeleik akcióterve. Azért (is) lehetnek eredményesek, mert mély megerősítéses tanuláskor és teszteléskor az MI-k ugyanazt a környezetet használják, és soha nem lehetünk biztosak, hogy a modell hogyan reagál új helyzetekre.