Mesterségesintelligencia-fejlesztők internetes adatokat használva javítják nagy nyelvmodelljeiket, az LLM-eket. Vállalatvezetők és kutatók, köztük a Google DeepMind CEO-ja, a friss Nobel-díjas Demis Hassabis viszont figyelmeztetnek, hogy a szektor pár évvel ezelőtt elképzelhetetlennek tűnt problémával szembesül: kifogyunk az MI-rendszerek gyakoroltatásához nélkülözhetetlen adatokból.

A konszenzus általánosnak tűnik. Azért jutunk el az adathiányig, mert az interneten található digitális szövegek nagy részét felhasználták már. Hiába költenek súlyos dollármilliárdokat MI-fejlesztésekre, a probléma fennáll, és egyre sürgősebb lenne megoldást találni rá.

Minél több internetes tartalmat, például híreket, chat-naplókat, blogokat és másokat fogyasztanak, annál jobbak az MI-rendszerek. A jelenségben rejlő lehetőségeket kihasználó nagyvállalatok, mint az OpenAI, a Google és a Meta gőzerővel dolgoznak azon, hogy még több online adathoz jussanak hozzá. Eddig gyakran figyelmen kívül hagyták a klasszikus céges politikát, ügyeskedtek, és a törvényeket sem tartották be az utolsó betűig.

A méretezési törvények kialakulásával, az előző három-négy évben a befektetések is kezdtek megtérülni, kilőtt a szakterületi fejlesztés, ami viszont ma már inkább lassulgat. Adjuk még hozzá, hogy a mostani módszerekkel egyes területeken ugyan kétségtelenül töretlenül fejlődik az MI, különben viszont új módszerekre lenne szükség a Google és az OpenAI által követett cél, az emberi intelligenciával azonos szintű, az emberi agy kapacitását minimum elérő mesterséges intelligencia megvalósításához. Pedig Sam Altman nemrég már 2025-re ígérte ezt, azaz az AGI-t (általános mesterséges intelligenciát) – ami inkább tűnik jó marketingszövegnek, mint valóságnak.

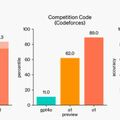

Hassabis a megtérülések csökkenő mértékére figyelmeztet. A Google DeepMind és mások is szintetikus adatokat generálva, módszereket dolgoznak ki arra, hogy az LLM-ek próbáikból és hibáikból (trial-and-error) tanuljanak. Az OpenAI nemrég be is mutatott szintetikus (gép által, például gépi tanulás közben generált) adatok használatával épített új rendszert, de az csak olyan területeken működik jól, ahol egyértelműen meg lehet különböztetni az igazat a hamistól: matematikában, programozásban és más egzakt tudományokban. A művészetek és a társadalomtudományok, a filozófia nagyobb kihívást jelentenek.

MI-rendszerek köztudottan hajlamosak hibázni és valótlanságokat fabrikálni. Ez a tény lassíthatja a saját programokat író és az online felhasználó érdekében cselekvő MI-ágensek fejlesztését. Egyre több kutató véleménye, hogy ezek az ágensek kulcsfontosságúak, nem lesz nélkülük AGI.

Az érintett nagyvállalatok mindenesetre nem kívánják csökkenteni az MI-rendszereknek otthont adó masszív adatközpont-építési beruházásaikat. Sokan nem is aggódnak, például az OpenAI szerint egyes módszertani módosításokkal, a fejlődés tempója sem lassul le.