A hétköznapokban is, bíróságokon viszont különösen fontos, ha meg tudjuk állapítani, hogy valaki hazudik. Ez a képesség segíthet dönteni személyek ártatlanságáról és bűnösségéről.

Régóta próbálkoznak a folyamat gépesítésével, élettani jellemzőkkel dolgozó hazugságvizsgálók már az 1930-as években léteztek, de a mai bíróságokon nem véletlenül nem engedélyezett a használatuk, akárcsak a kétes igazságszérumoké sem.

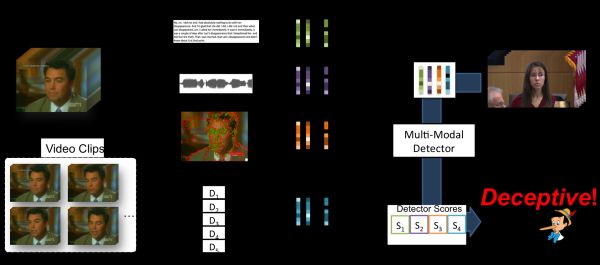

A Maryland Egyetemen (UMD) tárgyalások videóin a hazudozást emberi segítség nélkül detektáló rendszert fejlesztettek. A DARE (Deception Analysis and Reasoning Engine, Megtévesztés-elemzés és következtető rendszer) rengeteget tanul, hogy az adatok alapján képes legyen emberi mikrokifejezések (ajakbiggyesztés, felhúzott szemöldök stb.) felismerésére, illetve az igazmondást vagy a hazudást jelző hangmintákat kimutató audiofrekvencia-elemzésekre.

A kutatók szerint fejlesztésükre nem a „pontosság” a legjobb szó, mert egyes hírek, újságcikkek rosszul értelmezik, félreértik, valószínűségekkel keverik össze a pontosságot.

A teszteken a DARE a kiválasztott (nem igazságügyi szakértő stb.) alanyoknál jobban észrevette a hazugságokat. A kutatók különösen a humán résztvevőkre jelentősen ráverő látásmodullal elégedettek. Az ember által készített címkékkel ellátott mikrokifejezéseknél a kapcsolódó skálán 0,922-t, címke nélkül 0,877-et ért el, míg az emberi átlag 0,58 volt.

„A projekttel nemcsak bíróságokra, hanem más esetekre is gondolunk” – nyilatkozta az Egyetem Automatizáció Kutatási Központjában dolgozó Bharat Singh, arra utalva, hogy fejlesztésüket a jövőben hírszerző ügynökségek is használhatják.

„Közösségi játékokban, például a Maffiában is végzünk ellenőrzött kísérleteket. Ezekből a játékokból könnyebb több adatot gyűjteni, és az algoritmusok alaposan kiértékelhetők. Arra számítunk, hogy a kontrollált beállítások mellett fejlesztett algoritmusok más forgatókönyvekre is általánosíthatók” – magyarázza Singh.

Raja Chatilla, az IEEE (Institute of Electrical and Electronics Engineers) mesterséges intelligenciák és autonóm rendszerek etikájával foglalkozó bizottságának vezetője szerint, ha a DARE emberi sorsokról nyilatkozik, figyelembe kell venni a korlátait és a környezetet is. Ne ő döntsön, hanem a humán bírónak segítsen a döntéshozásban.

„A nagy valószínűség nem bizonyosság” – hangsúlyozta, majd kiemelte, hogy nem mindenki viselkedik egyformán. Ráadásul az MI tanításához használt adatokat sem mindegy, hogyan választják ki, mert a rosszul kiválasztott adatok a rendszer elfogult, részrehajló döntéséhez vezethetnek.

Singh szerint csak 3-4 évre vagyunk az emberi arc- és más kifejezések mögötti érzelmekből a hazudozást gond nélkül kiolvasó mesterséges intelligenciától.