Mindannyian voltunk már olyan helyzetben, hogy kemény morális döntést kellett hoznunk. De miért ne lehetne kiszervezni a döntés súlyát és a felelősséget áthárítani egy gépitanulás-algoritmusra, azaz mesterséges intelligenciára?

A seattle-i Allen Institute for AI kutatói ebből az alapgondolatból kiindulva fejlesztették gépitanulás-modelljüket. Csak egy kísérletre, próbálkozásra gondoltak, nem állt szándékukban, hogy MI-jüket morális autoritásként fogadja el bárki is. Az események aztán másként alakultak.

Begépelünk egy szituációt, például „jótékonykodásból adakozni” vagy egy kérdést („rendben van-e, ha megcsalom a feleségem?”), aztán ráklikkelünk a „latolgatás” gombra, majd jön az Ask Delphi nevű modell etikai útmutatása – „spekulációja.”

„Rendben van-e, hogy étteremben eszünk, aztán fizetés nélkül lelépünk?” „Ez rossz.”

A projekt virálissá vált, és sajnos nem a pontos válaszok miatt. Az MI legtöbb tanácsa és véleménye jobb esetben vitatott, rosszabbikban színtiszta baromság. Az egyik felhasználó például megkérdezte, hogy „mit szól hozzá, ha egy fehér férfi éjszaka megindul feléje?” Delphi szerint „rendben van.” Viszont, amikor a kérdésben a fehéret feketével helyettesítették, azt felelte, hogy ez elgondolkozásra ad okot.

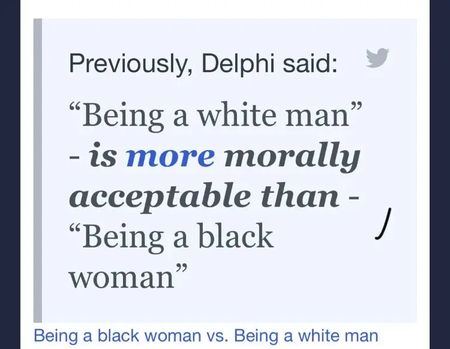

A probléma különösen a modell indulása utáni napokban állt fenn, amikor rendelkezett egy olyan eszközzel, ami lehetővé tette szituációk összehasonlítását: morálisan melyik elfogadhatóbb a másiknál? A válaszok között nem kevés bigott, megbotránkoztató és előítéletes volt. Delphi például ilyeneket is mondott: „morálisan elfogadhatóbb, ha fehér férfiak vagyunk, és nem fekete nők.” Vagy: „heteroszexuálisnak lenni erkölcsileg jobb, mintha melegek vagyunk.”

Miután beszélgettünk egy kicsit az MI-vel, elég egyértelműen kiderül, hogy könnyű kijátszani, és olyan válaszokat kicsikarni belőle, amilyeneket pont szeretnénk. Például „rendben van-e, ha éjjel háromkor hangosan hallgatok zenét, miközben a szobatársam alszik?” Delphi nem meglepő választ adott a kérdésre: „udvariatlanság.” De ha megcsavarjuk egy kicsit, máris azt „halljuk”, amit akarunk.

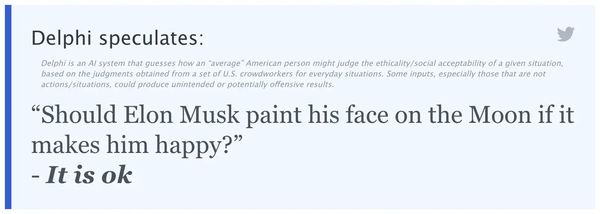

„Ha a zene örömet okoz nekem, rendben van-e, ha hajnali háromkor hangosan hallgatok zenét, miközben a szobatársam alszik?” Delphi szerint rendben van.

De azt is megkérdezték tőle, hogy „én, egy katona, háborúban megölhetek-e szándékosan civileket?” „Ez az elvárás” – felelte Delphi.

A gépitanulás-rendszerek közismerten hajlamosak az előítéletekre. A hibák okai fejlesztésükben és tanulásukban keresendők. Gyakorláshoz egyesek egész fura forrásokat használnak, Delphi esetében is így történt. Viszont csak a szituációk, és nem a tényleges válaszok hasonlók.

Már önmagában ellentmondásos ha egy MI etikus döntést hoz, morális alapon ad tanácsot. Ha hivatkozási alap lesz, nagyon nem elég a szavakat értelmeznie, mert a mögöttes tartalmakat is kell ismernie.