Két japán kutató, a szöveges utasításokból, promptokból képeket létrehozó egyik legismertebb modellt, a Stable Diffusiont használó módszert dolgozott ki tesztalanyok agya által látott képek rekonstruálására.

Azaz, arra keresték a választ, hogy mit lát az agy, amikor ránéz egy képre. Az alanyok agyát éppen ezért pont akkor szkennelték le, amikor tekintetük a képekre meredt.

Gyakorlás közben, a szöveget képpé alakító MI „zajos” képpel és szöveges leírással kezd. Egy modell beágyazza a leírást, egy diffúziós modell pedig megtanulja, hogy a beágyazással egymást követő lépésekben eltávolítsa a képben lévő zajt.

Így történik maga a képgenerálás folyamata is: a rendszer tiszta zajjal és a leírással indít, majd a szövegnek megfelelően, iteratív módon távolítja el a zajt ahhoz, hogy elkészüljön a kép. Úgynevezett látens diffúziós modellekkel kevesebb számítással végezhető el az egész folyamat.

A Stable Diffusion más látens diffúziós szövegből képet generáló modellekhez hasonlóan, különböző beágyazásokat használ kapcsolódó képekhez és szöveges leírásokhoz.

Az emberi agy a szembe érkező inputot feldolgozó területe az input szenzorikus és szemantikus aspektusait kezelő részekre osztható. Funkcionális mágneses rezonanciás képalkotással (fMRI) végzett szkeneknél, ezek a területek külön-külön beágyazhatók a szokásos kép- és szöveg-beágyazásokhoz. A kutatás alanyaival ilyen szkeneket végeztek.

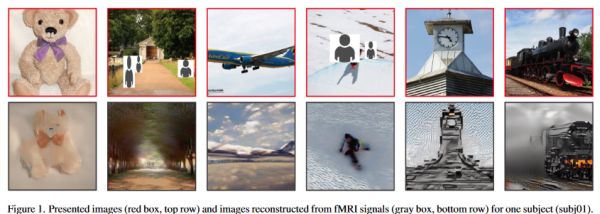

Ezeket a beágyazásokat használva, kiderült, hogy a Stable Diffusion létre tudja hozni az adott személy által agyszkennelés közben látott képet.

A kutatók megállapították: munkájuk annyira eltér a hasonló korábbiaktól, hogy nincs értelme kvantitatív összehasonlításnak. Minőségi szempontból, a témákhoz generált képek nagyjából ugyanazokat a jeleneteket ábrázolták, mint az alapképek, a részletek, egyes részletek viszont eltértek.