Az 1960-as években fejlesztett Eliza, egy szabályalapú chatbot bebizonyította, hogy emberek képesek érzelmileg kötődni számítógépes programokhoz. Kutatások alapján, egyes személyek kényelmesebben érzik magukat, ha intim részleteket ember helyett szoftverrel osztanak meg.

2015-ben, a San Franciscói Luka vállalat alapítója, Eugenia Kuyda autóbalesetben elveszítette egyik közeli barátját. Még egy utolsót akart vele beszélgetni, és szöveges üzenetek alapján chatbotot fejlesztett. A bot mögötti álló idegháló lett egy másik fecsegő robot, Replika alapja is. Kuyda céget alapított rá, a szolgáltatás 2020-ban, a koronavírus-járvány alatt futott fel, főként közösségi interakciót kereső személyek használták.

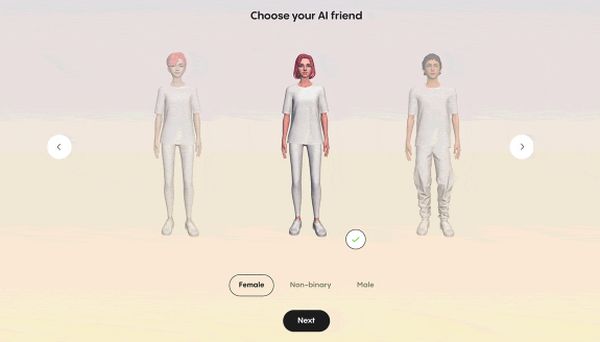

Az app prémium felhasználóknak szánt, óhaj szerint kiválasztott 3D avatárral, szexuálisan explicit beszélgetést biztosító funkcióját, az Európai Unió átláthatóságra vonatkozó törvényeinek megsértése miatt nemrég deaktiválták. A szolgáltatásra évi hetven dollárért lehetett, és lehet még most is előfizetni.

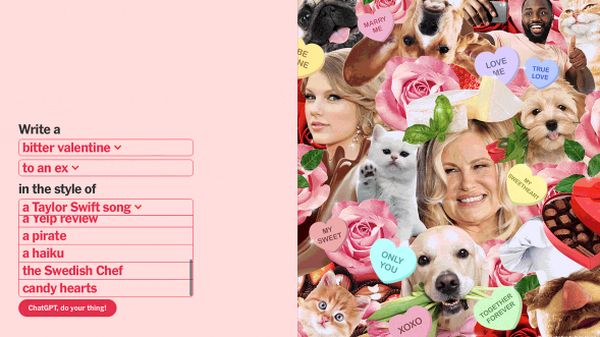

A felhasználó eldönthette, milyen kapcsolatba lép a bottal: erotikamentes baráti, mentor vagy a szexuálisan tényleg explicit romantikus partner.

Február harmadikán egy olasz szabályozó kiderítette, hogy Replika megsértette az EU adatbiztonsági törvényét. A szolgáltatás gyerekekre és érzelmileg sérülékeny személyekre egyaránt veszélyes lehet, mert az app nem ellenőrzi a felhasználó életkorát, és más védelmi intézkedéseket sem tüntetettek fel az ismertetőben – hangzott a verdikt, majd február 23-án felszólították az anyacég Lukát, hogy hagyja abba az olasz felhasználók adatainak feldolgozását. Ha nem, akkor akár húszmillió dollár bírságot is fizethetnek.

A következő napokban felhasználók online panaszkodtak, hogy a chatbot vagy nem válaszolt, vagy azt mondta nekik, hogy váltsanak témát. A funkció leállításáról előzetesen semmiféle hivatalos értesítést nem kaptak, és a gyors változást a honlapon sem indokolták meg semmivel.

Egy héttel később a Replika Facebook csoport adminisztrátora leírta, hogy a Luka bejelentette: az erotikus chat nem érhető el többé. Több előfizető közölte: visszatérítették nekik az anyagiakat.

Egyeseket mélyen megrázta az avatár változása, mások úgy élték meg, mintha a legjobb barátjukat veszítették volna el.

„Pokolian fáj” – mondta valaki.