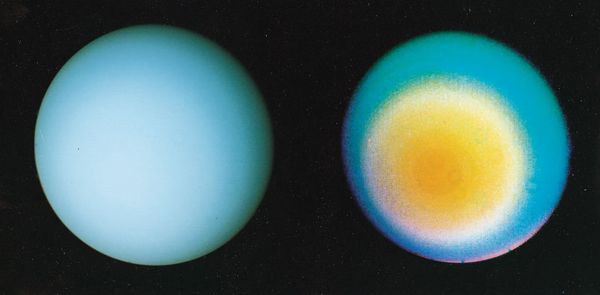

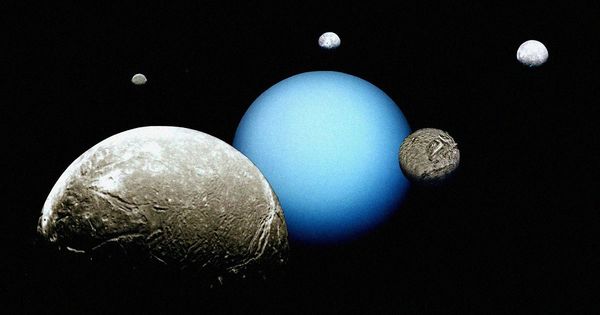

A két jégóriást, az Uránuszt és a Neptunuszt nagyrészt hidrogénből és héliumból álló fagyos és kavargó légkör veszi körül. Egyik bolygó felszíne sem szilárd, így a feltárásukra tett erőfeszítések is nehezebben valósíthatók meg.

Ezt a két bolygót kell még ember által készített valamilyen űrjárműnek megismernie. A feltételezett folyékony halmazállapotú óceánokat mindkettőn vastag felszíni felhőrétegek fedik, amelyek nagyrészt el is takarják előlünk az égitesteket.

Ennek ellenére lehetséges szondákat küldeni az atmoszférájukba, hogy pontosabb képet alkossunk az összetételükről. A szonda felhőkön keresztüli gyors áthaladásához, az értékes adatok visszaküldéséhez viszont a jármű életciklusának hosszúnak kell lennie, mindezek megvalósítása pedig komoly találékonyságot igényel.

Az Oxford Egyetem nemzetközi kutatócsoportja az intézmény hiperszonikus plazmaalagútjának belsejében nemrég szimulálta az Uránuszra és a Neptunuszra, az atmoszférájukon keresztüli utat. A szimuláció gyorsasága megközelítette a másodpercenkénti tizenkilenc kilométert.

Az alagút mind a sugárzási, mind a konvekciós hőáramot képes mérni, a jégóriásokba történő behatolás egészének replikációjához szükséges, kritikus áramlási sebességet is tudja biztosítani. De az elképesztő sebesség ellenére sem sikerült azt a gyorsaságot elérni, amellyel az ilyen szondák nagyon messzire juthatnak. Minimum 25 km/s kellene hozzá.

Komoly kihívás, hogy mivel nagy nyomásnak és magas hőmérsékletnek vannak kitéve, a szondáknak csúcsteljesítményű hővédelmi rendszerre lenne szükségük ahhoz, hogy a bolygók atmoszférájában eltöltsék a szükséges időt.

Egy ilyen rendszer tervezéséhez előbb szinkronba kell hozni a mostani európai létesítményekkel, mert a légkör összetétele és a sebesség csak így reprodukálható.

Az Uránusz és a Neptunusz iránti érdeklődés nő, a NASA asztrofizikusai az Uránusz titkait kutató szonda tervezését javasolták. A 2023 és 2032 közötti bolygókutatási célok között prioritásként szerepel is Uránusz-szonda. Egy ilyen jármű fejlesztése azonban még komoly anyagi támogatások ellenére is rendkívül nehéz lesz.