November elején az OpenAI újabb eredményeket, Elon Musk xAI-ja a ChatGPT-vetélytársnak szánt Grok chatbotot, Kai-Fu Lee nyílt forrású nagy nyelvmodellt (Yi-34B) jelentett be. Ezzel egyidőben a Fehér Ház és az MI Biztonsági Csúcs huszonnyolc országból, köztük az USA-ból és Kínából összesereglett résztvevői az MI-újításokat lelassító, a nyílt forrású kezdeményezéseket korlátozó szabályozáson dolgoztak. Az amerikai álláspont ugyan visszafogottabb az európainál és különösen a kínainál, a túlzó és indokolatlan megszorítások viszont mindig az innováció halálát jelentik.

Az OpenAI fejlesztői napján több új eszközt mutattak be – természetesen fejlesztői használatra. A cég teljesítménye az utóbbi években egyszerűen lenyűgöző, ráadásul azt is bizonyította már nem egyszer, hogy a megrendelt termékek leszállítását is gyorsan végzi.

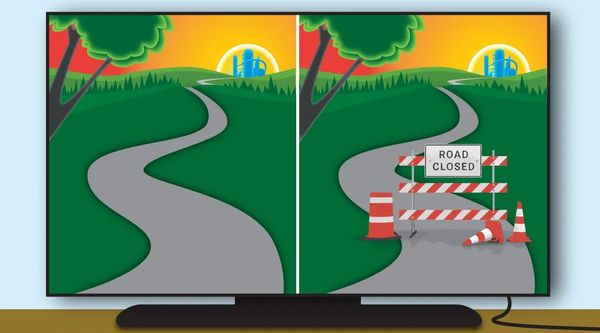

Sok vállalat tanulhatna tőle egy olyan korban, amikor a fejlesztők számára elérhető eszközök, a generatív MI-hez használt technológiák döbbenetes tempóban fejlődnek. A döntéshozás és a kivitelezés gyorsasága kulcstényezők egy mai startup sikerében. Ezzel szemben, egyes cégeknél viszont kisebb kiegészítők leszállítása is hónapokat vehet igénybe. A jogi, a marketinges és az adatvédelmi felülvizsgálat a késés leggyakoribb oka.

Nyilvánvaló, hogy a gyorsasággal nem minden fejlesztés válik be. Az OpenAI annyi újítást, funkciót jelent be, hogy garantálható: lesznek közöttük sikertelenek is. A GPT store az egyik – minden bizonnyal sikerré váló – frissen bemutatott innováció, ahol a fejlesztők speciális rendeltetésű chatbotokat a mobil appok mintájára terjeszthetnek.

A kivitelezés dinamikája viszont előrevetíti a sikert – persze nemcsak az OpenAI esetében, hanem azoknál a fejlesztőknél is, akik az új funkciókat termékek kidolgozásához használják fel. Fejlesztőként, a rendelkezésükre álló, gyorsan növekvő eszközkészlet lehetővé teszi a gyors kivitelezést, teljesen új termékek létrehozását. Egyszerű oknál fogva: a hozzájuk használt eszközök nem léteztek korábban.

Andrew Ng világhírű gépitanulás-szakértő szerint a gyors és persze felelősségteljes fejlesztések korát éljük. Ez azt is jelenti, hogy le kell rövidíteni az időt, amíg az alkalmazások mindenkihez eljutnak. Az OpenAI folyamatosan jó példát mutat.

Másrészt, nem a túlszabályozással fogjuk felgyorsítani.